Pride: marketingtips en hoe je vergissingen vermijdt

Juni is Pride-maand en vele bedrijven gebruiken dit als een marketingmoment. Maar waar moet je rekening mee houden?

Als website-eigenaar is het natuurlijk je wens om in de top van alle zoekresultaten te komen. Dit is in principe haalbaar, als Google je website goed vindt. In dit artikel hebben we het over crawl budget, leggen we uit wat het is en wat het te maken heeft met het vergroten van je zichtbaarheid in termen van ranking.

Iedereen die met SEO werkt, heeft hetzelfde doel: een goede positie in de zoekresultaten, bij voorkeur op de eerste pagina.

Er zijn veel dingen die je kunt doen en optimaliseren als je dit doel wilt behalen. Gebruik de juiste trefwoorden, creëer goede content en gebruik interne en externe links. In dit artikel leggen we uit hoe je dit het beste kan doen en hoe je het meeste uit je crawl budget kunt halen!

Het concept van het crawl budget is zeer technisch; we proberen op een eenvoudige manier uit te leggen wat het precies is en hoe je het kunt optimaliseren.

Voordat we beginnen, moeten we nog drie kernbegrippen kort toelichten. Vaak worden deze termen als synoniemen gebruikt, maar in werkelijkheid hebben ze verschillende betekenissen.

Dit is wat er wordt bedoeld met het scannen, indexeren en positioneren van een pagina:

Dat gezegd te hebben, kunnen we beginnen.

Crawl Budget is het moment waarop Google besluit te investeren in het indexeren en scannen van de pagina's van een site.

Laten we die definitie nu onderzoeken:

De Googlebot is verantwoordelijk voor het scannen van elke pagina op het web. De Googlebot voert één keer per maand de deep-crawl uit en bijna elke dag de fresh-crawl.

De Googlebot bezoekt zoveel mogelijk URL's omdat Google inhoudelijk hongerig is: het doel is om op de hoogte te blijven van nieuwe inhoud op het web om gebruikers een relevant antwoord te geven op hun zoekopdrachten.

De tijd die Googlebot besteedt aan het indexeren en scannen van je pagina's (en alle andere) is niet onbeperkt, integendeel, niet alle URL's worden regelmatig gescand. Daarom is het optimaliseren van je crawl budget cruciaal; als je pagina’s kwalitatief goed zijn, zullen ze makkelijker te lezen zijn en zal Googlebot meer tijd hebben om ook alle andere pagina’s te lezen.

Meer pagina's geïndexeerd of gescand door Googlebot betekent een grotere kans om bij de eerste SERP-resultaten te verschijnen.

Als Googlebot een pagina niet scant, wordt deze niet geïndexeerd en verschijnt deze helemaal niet in de SERP.

Googlebot zal geen tijd en middelen verspillen aan pagina's waarvan het denkt dat de kwaliteit niet hoog genoeg is, of als het denkt dat deze geen toegevoegde waarde hebben voor de zoektocht van gebruikers.

De vragen die op dit punt spontaan zullen opkomen zijn:

In het volgende hoofdstuk zullen we de antwoorden geven.

Maar eerst is er nog het feit dat het crawl budget niet voor iedereen is. Kleine sites met weinig pagina's hoeven zich geen zorgen te maken. Dit is meer relevant voor grotere sites, zoals redactiesites en grote e-commerce-sites, die de gebruikers up-to-date-resultaten moeten laten zien.

Stel je voor dat je een voetbalwedstrijd volgt: natuurlijk verwacht je dat de resultaten die je in de SERP vindt, de score in real time laten zien en niet 15 minuten geleden.

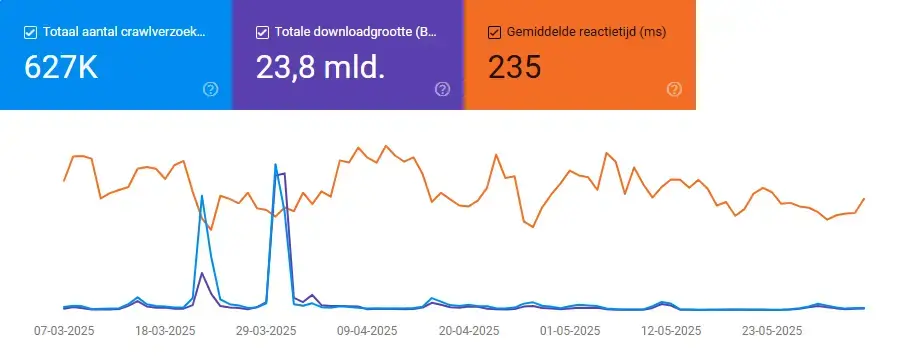

Om de activiteit van Googlebot op je site bij te houden, is de Google Search Console een handig en gratis hulpmiddel. Deze tool stelt je in staat om uit te vinden hoeveel aanvragen per seconde de zoekmachine aan jouw site wijdt en hoeveel tijd er verstrijkt tussen de scans.

Het ontdekken van de Googlebot activiteit in de afgelopen 90 dagen is eenvoudig. Je kunt de scanstatistieken op deze manier bekijken:

Hier ziet u 3 waarden:

Wat crawlverzoeken betreft, kan worden gezegd dat hoe hoger de waarde, hoe beter. Het tegenovergestelde geldt voor de andere twee waarden. Door het gewicht van de pagina's te optimaliseren, kunnen zowel de crawler als de gebruikers er sneller door bladeren.

Bovendien betekent een snellere download dat er meer pagina's kunnen worden gecrawld met het beschikbare crawlbudget.

Mocht je budget niet zo hoog zijn, is dat geen probleem. Er zijn enkele eenvoudige trucjes om de spin van Google te overtuigen om je meer te overwegen.

Google is nieuwsgierig. Om Google te overtuigen om terug te komen op jouw website, kun je deze punten volgen:

De populariteit van een pagina is essentieel. Zoals Google zelf zegt: ‘’De populairste URL’s op het internet worden vaker gecrawld om ze verser in onze index te houden’.’

Urenlang heb je bovenstaande tips gevolgd en ben je erin geslaagd om de aandacht van Google te trekken. Nu is het tijd om je te richten op SEO, of hoe je je crawlbudget kunt optimaliseren. Het concept van optimaliseren wordt hier opgevat als het benutten van de "kleine" tijd die Googlebot aan ons besteedt.

Het risico dat Googlebot kostbare tijd verliest, bijvoorbeeld op pagina's die geen toegevoegde waarde hebben voor gebruikers of die dubbele inhoud bevatten, is een zet die al je andere inspanningen tevergeefs zal maken. Iets wat je duidelijk wilt vermijden.

Houd dit concept altijd in gedachten:

Een populaire bron met recente of geüpdatet inhoud verhoogt het crawlbudget.

Integendeel, dubbele inhoud, lage kwaliteit of niet meer up-to-date, 404 pagina's, enz. verminderen het crawlbudget.

Hoewel het voor de hand ligt, moet worden gepreciseerd dat het creëren van een laag kwaliteitsniveau contraproductief is.

In feite bestaat het gevaar dat Googlebot tijd verspilt aan het scannen van diezelfde pagina's in plaats van zich te kunnen wijden aan die pagina's van jou die kwalitatief hoogstaand, populair en up-to-date zijn.

Google is al erg goed in zijn werk, maar je kunt helpen door dit werk makkelijker en (vooral) sneller te maken om je site te helpen.

Om dit te doen zijn er twee crawlbudgetwaarden die je kunt optimaliseren: verhoog je crawlbudget en verminder de tijd tussen de scans.

Snelheid is essentieel, omdat, zoals we al hebben gezegd, de tijd die Googlebot aan ons besteedt niet onbeperkt is. Het optimaliseren van de downloadtijd van een pagina betekent dat Googlebot meer tijd aan andere pagina's kan besteden. Enkele tips die je hiervoor kunt volgen zijn:

Je zult zeker bekend zijn met deze afbeelding, dat laat zien hoe een site idealiter moet worden gestructureerd. Een duidelijke en lineaire structuur van de pagina's van je site, zorgt dat je kunt profiteren van je crawlbudget (en we weten nu dat meer tijd gelijk staat aan meer gescande of geïndexeerde pagina's). Let op:

Interne links, die in principe dienen om diepte aan een bepaald onderwerp toe te voegen, moeten verwijzen naar de pagina's waar de Googlebot rekening mee moet houden.

Gebroken links straffen je niet alleen in termen van rangorde, maar verspillen ook het kostbare crawl budget dat je hebt.

No-follow-links besparen je crawl budget omdat ze de Googlebot vertellen geen tijd te verspillen aan het scannen ervan. Deze pagina's kunnen de pagina's zijn die je bepaalt als de minst belangrijke op je site of de pagina's die al gelinkt zijn binnen een bepaald onderwerp of een bepaalde categorie en die niet meerdere keren moeten worden gescand.

De robots.txt, een eenvoudig tekstbestand, is handig om oninteressante pagina's te blokkeren. Het biedt ook een gids voor de inhoud van elke pagina en vertelt Google hoe deze te crawlen.

Robot.txt is van essentieel belang als je wilt voorkomen dat je de tijd van de crawler verspilt met pagina's die niet gescand hoeven te worden. Dit kunnen privépagina's zijn of adminpagina's. Het is ook nuttig om aan te geven welke pagina's moeten worden gescand.

Je kunt het nooit genoeg zeggen: het updaten van je content leidt tot een toename van de tijd die Google eraan besteedt.

Het verwijderen van alle pagina's die niet meer relevant zijn of die niet veel verkeer hebben, voorkomt dat je je crawl budget verspilt. Als je de inhoud van deze pagina's niet volledig wilt verliezen, kun je deze verplaatsen naar (of combineren met) soortgelijke of nieuwe pagina's.

Vergeet in dit verband niet de backlinks. Als andere pagina's verwijzen naar een pagina die je op het punt staat te verwijderen, heb je twee opties: je kunt een 301 redirect doen, die de zoekmachine vertelt dat de pagina toegankelijk is vanaf een andere URL, of je kunt de backlink URL direct wijzigen.

De tijd tussen de ene scan en de andere is belangrijk betreft het crawl budget.

Door regelmatig je content te updaten, zul je een toename van de Googlebot-scans opmerken. Elke keer dat de Googlebot een pagina bezoekt en herziene inhoud vindt, krijg je een verhoging van het crawl budget.

Let wel op: publiceer een pagina pas opnieuw na een grote update. Als Google ziet dat de inhoud hetzelfde is, of erg op de vorige versie lijkt, zal deze jou straffen met minder vaker te crawlen.

Het beheren en verhogen van je crawl budget is het geheim van succes. Als je content goed is en je pagina's gemakkelijk te lezen zijn, zal een frequentere crawling vrijwel zeker leiden tot een verhoging van de zichtbaarheid (dat wil zeggen, een hogere ranking in SERP's).

Wat je altijd in gedachten moet houden is; wanneer je het over crawlbudget hebt, je altijd moet nadenken over het optimaliseren van je pagina's.

Update datum: 21 december 2021

Origineel gepubliceerd op: 6 februari 2020

Juni is Pride-maand en vele bedrijven gebruiken dit als een marketingmoment. Maar waar moet je rekening mee houden?

Ontdek hoe vertrouwenssymbolen (keurmerken en beoordelingen) de betrouwbaarheid van je marketing en webshop vergroten.